Начало читайте здесь

Когда человек халтурит

В 1945 году британский математик Алан Тьюринг с командой взломали код машины Энигма, чем существенно повлияли на ход Второй мировой войны. Он же в 1950-м предложил такой тест, который определял бы, достигла ли вычислительная машина таких качеств, что при взаимодействии с ней мы не можем отличить, общаемся мы с человеком или нет.

Уже можно смотреть, в каких областях тест Тьюринга уже пройден, а в каких нет. О релевантности теста Тьюринга для современных ИИ ведутся споры. Считается, что он во многом устарел. В 2024 ChatGPT официально прошёл строгий тест Тьюринга. Но есть здесь и другой момент, о котором важно поговорить.

Главная проблема, кажется, не в том, что ИИ уже (или почти) пишет тексты, рисует, делает видео не хуже человека, а в том, что человек всё чаще делает свою работу не лучше машины. Это отмечают и преподаватели вузов, что иногда студент пишет всё сам, но за этим нет никакого человека.

Это, конечно, не новости. Испокон веков некоторые студенты проходили путём наименьшего сопротивления. Вопрос лишь в том, что во времена, когда «машина» пишет как человек, не нужен человек, который пишет и действует как машина. Не нужен учитель, который механически передаёт содержание учебника и проводит тестовый контроль знаний. Не нужен врач, который действует только по отработанным схемам и не видит человека. Не нужен священник, который повторяет одно и то же, не вкладывая ни разума, ни сердца в своё дело. И тем более представители многих других менее требующих человеческого вовлечения профессий в том же виде не будут нужны.

Фото: Киселев Сергей / Агентство «Москва»

Фото: Киселев Сергей / Агентство «Москва»Зловещая долина

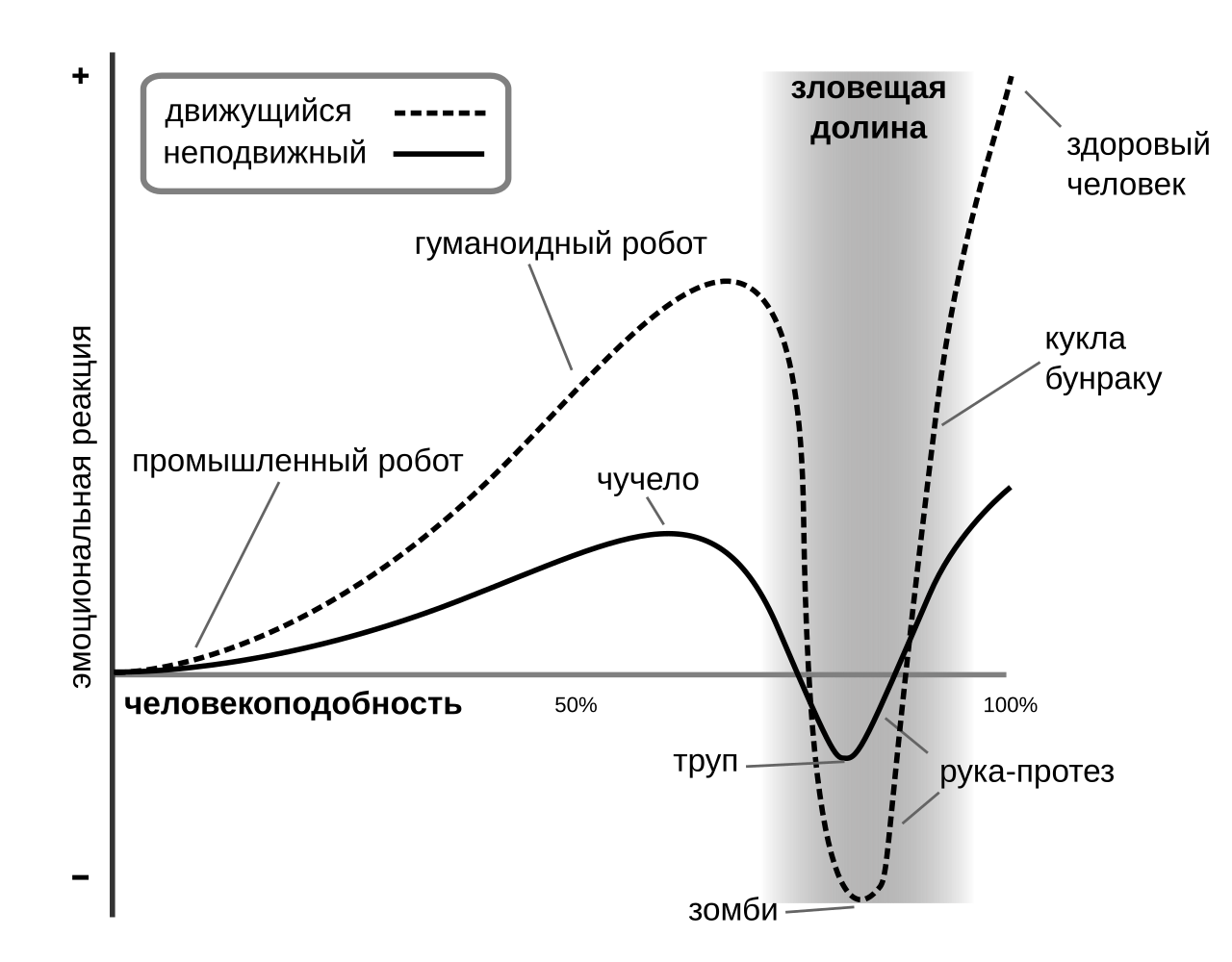

Есть, конечно, ещё эффект зловещей долины, который пока уберегает нас от полного неразличения ИИ и человека. Этот эффект связан с тем, что, когда мы видим что-то в реальности или на видео что-то, не очень похожее на человека (например, персонажей в мультфильме или умилительных роботов-доставщиков от Яндекса), то проблем не возникает. Когда же мы видим что-то, очень похожее на человека, но не совсем, то возникает сильное отторжение и испуг, а на графике это видно в качестве падения положительного отношения (долина на графике). В эволюционном отношении наверняка это было связано с дистанцированием от людей, болевших заразными болезнями, поведение которых сильно отличалось.

Фото: Smurrayinchester / Wikipedia

Фото: Smurrayinchester / Wikipedia

В отношении роботов, слишком похожих на людей, и текстов, слишком похожих на человеческие, возникает примерно тот же эффект: отторжение, неприятие и т.п.

Если поработаешь с нейросетями какое-то время, то уже почти сразу чувствуешь в тексте «запах машинного масла».

И это ставит с ещё большей остротой вопрос: что значит быть человеком?

Есть вариант, предложенный А.Ф. Филипповым, что в дополнение к бесконечно создаваемым нейросетями текстам нужно создать нейросеть – бесконечного потребителя, который, однажды проснувшись, пожалеет о выброшенных на свалку часах, днях и годах, потраченных на потребление.

А пока один ИИ производит, а другой ИИ потребляет, люди наконец смогут поговорить.

Это, конечно, не вопрос о soft skills – «мягких навыках», которые так востребованы в последние время, может быть, из-за того, что все разучились общаться. Есть прекрасное и довольно краткое философское эссе немецко-корейского автора Бён Чхоль Хана «Кризис повествования. Как неолиберализм превратил нарративы в сторителлинг», в котором автор настоятельно взывает, что людям нужно вновь научиться рассказывать и слушать истории не для того, чтобы продать и купить, а для того, чтобы быть самим и быть вместе.

Если Честертон ещё 100 лет назад печалился, что люди разучились петь вместе, что бы он сказал сейчас?

Фото: Сандурская Софья / Агентство «Москва»

Фото: Сандурская Софья / Агентство «Москва»